عن حَوْكَمَة الذكاء الاصطناعيّ

ممدوح مبروك*

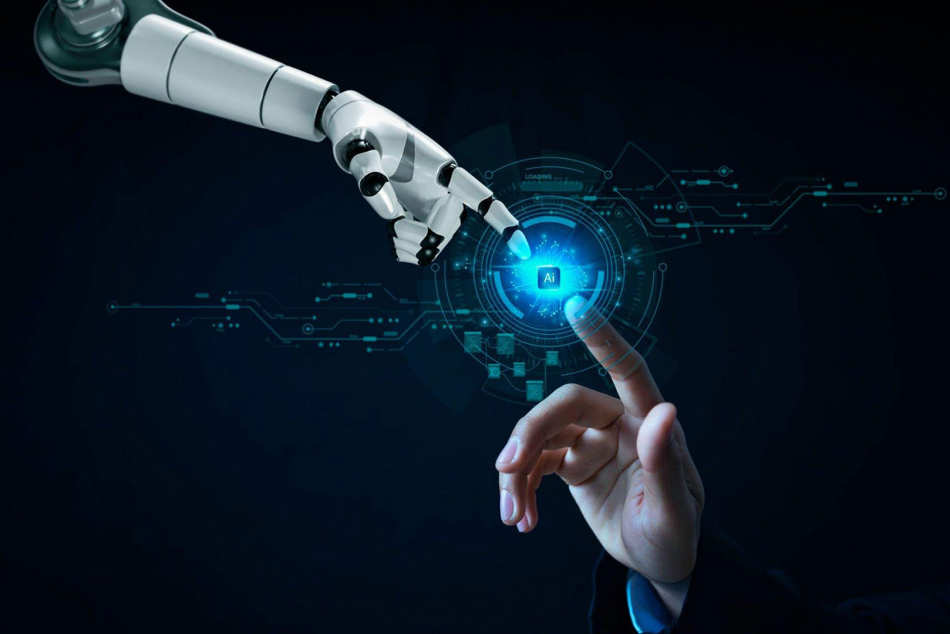

على الرّغم من إيجابيّات تقنيّات الذكاء الاصطناعيّ، إلّا أنّ الأضرار الناجمة عن استقلاليّتها المُطلقة وتطوُّرها المُتسارِع، صارت أمراً في منتهى الخطورة، ولاسيّما أنّ الجهود المبذولة لحَوْكَمَة الذكاء الاصطناعيّ لا تُواكِب حَجْمَ التطوّرات التكنولوجيّة التي شهدها العالَمُ خلال السنوات الأخيرة، بسبب تعثُّر الجهود التنظيميّة، وانتشار نماذج الذكاء الاصطناعيّ وأدواته خارج سيطرة الحكومات. وبالتالي أصبحت الحاجة ماسّة لاستحداثِ أنظمة حَوْكَمَة قويّة ومَرِنة قادرة على التكيُّف، وتَضمن المُساءلة.

تستند حَوْكَمَة الذكاء الاصطناعي بشكلٍ أساسي إلى الجانب الأخلاقي، وبالتالي يتعيَّن على الهيئات التنظيميّة والشركات مُعالَجة المخاوف الأخلاقيّة، كالتمييز والحدّ من إساءة الاستخدام وإدارة خصوصيّة البيانات وحماية حقوق الطبع والنشر وضمان الشفافيّة، فضلاً عن ضرورة فَهْم حَجْم التهديدات والمخاطر النّاجمة عن تطوُّر تقنيّات الذكاء الاصطناعي المتمثّلة في ما يلي وإدراكها:

أوّلاً: التضليل؛ حيث يتمّ استخدامُ تقنيّات الذكاء الاصطناعي من طَرَفِ الجهات الفاعلة محليّاً ودوليّاً للتأثير على الحملات الانتخابيّة، وتأجيج الانقسام، وتقويض الثقة في الديمقراطيّة، وزَرْع الفوضى السياسيّة على نطاقٍ غير مسبوق. كما يُمكن استخدام المعلومات المضلّلة التي يولِّدها الذكاءُ الاصطناعي لتفاقُم الصراعات الجيوسياسيّة المستمرّة مثل: الحروب في الشرق الأوسط وأوكرانيا؛ فعلى سبيل المثال، استخدَم مروِّجو الدعاية في الكرملين مؤخّراً الذكاء الاصطناعي لنشْرِ قصصٍ مزيّفة عن الرئيس الأوكراني "زيلينسكي" على تطبيق تيك توك، وإكس، وغيرهما، والتي استشهد بها المشرِّعون الجمهوريّون بعد ذلك كأسبابٍ لضرورة سحْب الدَّعْم الأميركي لأوكرانيا.

أصبحت التكنولوجيا خطراً رئيساً في عمليّة اتّخاذ القرارات السياسيّة، حيث يتمّ استخدام الصور، والتسجيلات الصوتيّة، ومقاطع الفيديو على وسائل التواصل الاجتماعي بواسطة جيوش من "الروبوتات" التي تعمل بالذكاء الاصطناعي بغية التأثير على الرأي العامّ، وتشويه سمعة الأدلّة الحقيقيّة، وزيادة تأجيج التوتّرات الجيوسياسيّة حول العالَم.

ثانياً: سرعة الانتشار؛ حيث تُهيمن في الوقت الرّاهن الولايات المتّحدة الأميركيّة والصين على تقنيّات الذكاء الاصطناعي، ومن المتوقَّع أن يتمكَّن عديدٌ من الجهات الفاعلة كالدول والشركات من تطوير قدراتٍ خارقة واكتسابها باستخدام تقنيّات الذكاء الاصطناعي في المجالات المتعلّقة بالاستخبارات والأمن القومي. ومن ناحيةٍ أخرى، سيعمل الذكاء الاصطناعي على تعزيز قدرة العديد من الدول على تطوير الأسلحة، وإتاحة فُرصٍ اقتصاديّة كبيرة.

أطُر حاكمة

في ضوء التقرير الصادر عن مجموعة أوراسيا الاستشاريّة لتحليل المخاطر تحت عنوان "المخاطر الكبرى خلال عام 2024"، ثمّة أربعة مبادئ أساسيّة ينبغي أخْذها في الاعتبار لدى التعامُل مع قضيّة حَوْكَمَة تقنيّات الذكاء الاصطناعي خلال العام الجاري، وهي كالتالي:

أولاً: التنظيم. إنّ القاسم المُشترَك بين الحكومات هو عدم وجود اتّفاق حول كيفيّة التعامُل مع الذكاء الاصطناعي، وعدم وجود متطلّبات لتقييم تأثير أدوات الذكاء الاصطناعي على السكّان قبل طرحها. وبالتالي فإنّ إنشاء مؤسّسة للذكاء الاصطناعي على غرار الهيئة الحكوميّة الدوليّة المَعنيّة بتغيُّر المناخ (IPCC)، سيكون بمثابة خطوة أولى مفيدة نحو فَهْمٍ علمي عالَمي مُشترَك للتكنولوجيا وآثارها الاجتماعيّة والسياسيّة، إلّا أنّ هذا الأمر سيستغرق مزيداً من الوقت.

ثانياً: الجمود. إنّ اهتمام الحكومات بالذكاء الاصطناعي ليس أولويّة كبرى، ولاسيّما أنّ تنفيذ المُبادرات اللّازمة لحَوْكَمَة الذكاء الاصطناعي يتطلَّب مُقايضاتٍ صعبة من جانب الحكومات، وبالتالي يتطلَّب الأمرُ حدوثَ أزمةٍ كبيرة لإعادة طرح القضيّة مرّة أخرى.

ثالثاً: الانشقاق. قرَّر المُستفيدون من تقنيّات الذكاء الاصطناعي الإسهامَ في مسألة حَوْكَمَة الذكاء الاصطناعي، وذلك من خلال التزام شركات التكنولوجيا بالمعايير، إلّا أنه مع التقدُّم التكنولوجي، فإنّ المُغريات المُتزايدة للميزة الجيوسياسيّة والمصالح التجاريّة ستحفِّز الحكومات والشركات على الانشقاق عن الاتّفاقيّات والأنظمة غير المُلزِمة التي انضمَّت إليها لتحقيق أقصى قدرٍ من المكاسب.

رابعاً: السرعة التكنولوجيّة. من المقرَّر أن يستمرّ الذكاءُ الاصطناعي في مُضاعَفة قدراته كلّ ستّة أشهر تقريباً. وبالتالي فمن الطبيعي أن تتفوَّق التكنولوجيا على الجهود المبذولة لاحتوائها في الوقت الفعلي.

مُبادرات طموحة

على مدى السنوات القليلة الفائتة، شهدَ العالَمُ مَوجةً من المُبادرات الطموحة في مجال حَوْكَمَة الذكاء الاصطناعي على المستوى الدولي، حيث نَشَرَ عددٌ من المنظّمات الدوليّة متعدّدة الأطراف العديد من اللّوائح التي تتضمَّن أُطُرَ حَوْكَمَةِ الذكاء الاصطناعي بهدف تقديم مجموعة من الإرشادات اللّازمة لتطوير الذكاء الاصطناعي بشكلٍ آمنٍ مثل: "مبادئ منظّمة التعاون الاقتصادي والتنمية بشأن الذكاء الاصطناعي" الصادرة عن منظّمة التعاون الاقتصادي والتنمية في العام 2019، و"المبادئ التوجيهيّة الأخلاقيّة لذكاءٍ اصطناعي جدير بالثقة" الصادرة عن الاتّحاد الأوروبي في العام 2019، و"توصيات اليونسكو بشأن أخلاقيّات الذكاء الاصطناعي" الصادرة عن منظّمة اليونسكو في العام 2021، و"عمليّة هيروشيما لمجموعة السبع بشأن الذكاء الاصطناعي التوليدي" التي نَشَرَتْها منظّمة التعاون الاقتصادي والتنمية في العام 2023.

هذا بالإضافة إلى "إعلان بلتشلي" الصادر عن قمّة "سلامة الذكاء الاصطناعي الأولى" التي عُقدت في المَملكة المتّحدة في تشرين الثاني/ نوفمبر 2023، والذي بموجبه تعهَّدت 28 دولة، بالإضافة إلى الاتّحاد الأوروبي، بالعمل معاً لمُعالَجة المخاطر التي يشكِّلها الذكاء الاصطناعي.

على المستوى الوطنيّ

خلال السنوات الأخيرة، ظهرت وثائق توجيهيّة عدّة مثل: "إطار إدارة مخاطر الذكاء الاصطناعي" الصادر عن المعهد الوطني الأميركي للمعايير والتكنولوجيا (NIST) في كانون الثاني/ يناير 2023، و"مخطَّط البيت الأبيض لوثيقة حقوق الذكاء الاصطناعي" الصادر في تشرين الأوّل/ أكتوبر 2022. هذا فضلاً عن العديد من الاستراتيجيّات الوطنيّة للذكاء الاصطناعي الصادرة عن أكثر من 60 دولة في الأميركيَّتَيْن، وأفريقيا، وآسيا. وتجدر الإشارة إلى أنّ تلك الوثائق غير مُلزِمة، إنّما هي بمثابة دليلٍ إرشاديٍّ للهيئات التنظيميّة، ولصانعي السياسات في مُختلف أنحاء العالَم، وبالتالي فإنّ التنفيذ العَملي لها هو أمرٌ في غاية الصعوبة.

على المستوى التشريعيّ

تأتي مخاطر استخدام تقنيّات الذكاء الاصطناعي على رأس التشريعات المتعلّقة بخصوصيّة البيانات أو حقوق الإنسان أو المخاطر السيبرانيّة أو الملكيّة الفكريّة، وعلى الرّغم من ذلك، لا توفِّر تلك التشريعات نَهجاً شاملاً لآليّة التعامُل مع مخاطر الذكاء الاصطناعي.

ظهرَ في الآونة الأخيرة العديد من التشريعات على مستوى العالَم أبرزها: قانون الذكاء الاصطناعي للاتّحاد الأوروبي 2023، والذي يُعَدّ أوّل تشريع شامل للذكاء الاصطناعي في العالَم، يهدف بشكلٍ أساسي إلى توفير إطارٍ يتمحور حول الإنسان لضمان أن يكون استخدام تقنيّات الذكاء الاصطناعي آمناً، وشفّافاً، وقابِلاً للتتبُّع، وغير تمييزي، وصديقاً للبيئة، ومتوافقاً مع الحقوق الأساسيّة.

أيضاً أصدرت الصين مجموعةً من اللّوائح التنظيميّة لتقنيّات الذكاء الاصطناعي مثل: "خطّة تطوير الجيل الجديد من الذكاء الاصطناعي" في العام 2017، و"المُبادرة العالَميّة لحَوْكَمَة الذكاء الاصطناعي"، و"التدابير الإداريّة المؤقّتة لإدارة خدمات الذكاء الاصطناعي التوليديّة" في العام 2023.

وفي الولايات المتّحدة الأميركيّة، أَصدر الرئيس الأميركي "جو بايدن" أمراً تنفيذيّاً في 30 تشرين الأوّل/ أكتوبر 2023 بشأن وضْع ضمانات لتطوير استخدام الذكاء الاصطناعي بشكلٍ آمنٍ وجدير بالثقة. وفي هذا السياق تمَّ اقتراح تشريعَيْن رئيسيَّيْن على المستوى الفيدرالي، هُما: "قانون المُساءلة الخوارزميّة"، وقانون "الإفصاح عن الذكاء الاصطناعي".

على مستوى الشركات

تزايَدت الدعوات الموجَّهة للشركات لإدارة المخاطر المُتعلّقة بالذكاء الاصطناعي، سواء من وجهة نظر المُطوِّر أم المُستخدِم. حتّى وقتٍ قريب، تحمَّلَ مُطوِّرو الذكاء الاصطناعي العبءَ الأكبر في الاتّفاق على ضماناتٍ للحدّ من مخاطر التكنولوجيا؛ فعلى سبيل المثال، اتَّفَق المُطوِّرون السبعة الرئيسيّون في الولايات المتّحدة الأميركيّة مثل: Amazon، وAnthropic، وGoogle، وInflection، وMeta، وMicrosoft، وOpenAI في اجتماعٍ مع الرئيس "بايدن" في تمّوز/ يوليو 2023 على الالتزام ببعض المعايير المتعلّقة باستخدام تقنيّات الذكاء الاصطناعي وتنفيذ حواجز الحماية.

أمّا الآن، فيُطلَب من الشركات في جميع القطاعات توضيح كيفيّة استخدام الذكاء الاصطناعي بالشكل الذي يُقلِّل من تفاقُم المَخاطِر، ولاسيّما مع الإقبال الكبير على استخدامه. فعلى سبيل المثال خلال أوّل شهرَيْن من طَرْحِ تطبيق ChatGPT، سُجِّل أكثر من 100 مليون مُستخدِم، الأمر الذي أثار العديد من المخاوف المتعلّقة بخصوصيّة البيانات وانتهاكات حقوق الطبع والنشر.

حتّى الآن، أَحرز عددٌ قليل من الشركات تقدُّماً في مجال حَوْكَمَة الذكاء الاصطناعي. ومع ذلك، يظلّ القاسم المُشترَك بين معظم أُطر ومبادئ الذكاء الاصطناعي العالَميّة هو أنّ الشركات يجب أن تتّخذ نَهجاً أخلاقيّاً لدى بناءِ أُطر حَوْكَمَة الذكاء الاصطناعي؛ وفي هذا الصدد يقول "أرفيند كريشنا"، رئيس مجلس الإدارة والرئيس التنفيذي لشركة IBM، خلال القمّة العالميّة للحكومات في العام 2022: "يجب على الحكومات أن تُحسِّن وتُطوِّر استخدام التكنولوجيا والذكاء الاصطناعي لخدمة البشريّة، وأن توظّفها وفق أخلاقيّاتٍ لا يُمكن الاستغناء عنها، تتعلّق بصدق البيانات والمدخلات التي تزوّدها بها، وأن يتمّ تجاوُز العرقيّات والأجندات الشخصيّة لتحقيق الصدقيّة".

من المُفترَض أن تضطلع مجالس إدارات الشركات بدَورٍ حاسِمٍ في تحديد الفُرص الاستراتيجيّة الناشئة والإشراف على المخاطر، وخصوصاً تلك المرتبطة بالذكاء الاصطناعي. تتمثّل مسؤوليّة مجلس الإدارة في الإشراف على الإدارة، وتقييم مدى تأثير الذكاء الاصطناعي على استراتيجيّة الشركة، والنَّظر في كيفيّة تعامُل الشركة بشكلٍ فعَّال مع المَخاطِر، ولاسيّما تلك التي تشكِّل تهديداً لعملاء الشركة، وموظّفيها، وسمعتها.

كما هو الحال مع العديد من القضايا الناشئة، مثل المخاطر السيبرانيّة، فإنّ الرقابة الفعَّالة على الذكاء الاصطناعي ستتطلَّب من مجالس إدارات الشركات أن تكون على دراية بالذكاء الاصطناعي، وبالتالي فإنّ الفَهْم العملي للذكاء الاصطناعي، إلى جانب عمليّة مُراقَبة قويّة وشاملة لضمان المُساءلة، هي متطلّبات أساسيّة حاسِمة للإشراف على إنشاء أُطرٍ إداريّة قويّة قادرة على مُواجَهة مخاطر الذكاء الاصطناعي على المستوى التنفيذي.

في ضوء ما سبق، يُمكن القول إنّ حَوْكَمَة الذكاء الاصطناعي هي في المقام الأوّل مسألةٌ أخلاقيّة، وبالتالي فإنّه كلّما طال أَمد بقاء الذكاء الاصطناعي خارج نِطاق السيطرة بسبب النفوذ الذي تتمتّع به الشركات التكنولوجيّة، زادَ خطر حدوث أزمةٍ نظاميّة، وأصبح من الصعب على الحكومات اللّحاق بالركب.

*باحث سياسي من مصر

مؤسسة الفكر العربي